Запускаете сайт? Поздравляем! Прежде чем устремиться к вершинам топа Яндекс или Google, проверьте, не забыта ли одна маленькая, но значительная деталь — файл robots.txt

Robots.txt — текстовый файл в главной директории веб-ресурса, который инструктирует роботов-поисковиков. В первую очередь, содержание файла подсказывает, какие страницы нужно индексировать, а какие — не стоит.

Наличие файла robots.txt на сайте — непременное условие: он полезен для продвижения, кроме того, без него невозможно добиться высоких позиций в выдаче Яндекс, Google и других поисковых систем.

Зачем нужен файл robots.txt

Перед тем, как начать индексировать сайт, дружелюбный робот-поисковик сразу обратит внимание на robots.txt — прочитает инструкции и лишь затем приступит к работе. От того, как составлен файл, напрямую зависит успех или неудача кампании по продвижению, а также сохранность приватных данных на сайте.

Если robots.txt заполнен верно, ресурс получи:

- быструю и правильную индексацию страниц

Без файла robots.txt или при неверном его составлении поисковая машина может добавить в результаты выдачи нерелевантные страницы — например, экран авторизации и регистрации. Такой “мусор” будет конкурировать с целевыми страницами, и в поисковой выдаче окажется совсем не то, что хотелось бы видеть.

К тому же, это негативно повлияет на поведенческие факторы, а значит, сайт “просядет” в выдаче.

- защиту приватной информации и личных данных

Чтобы администраторская панель сайта, а также личные данные и пароли, не оказались доступны всем пользователям интернета — закройте приватные страницы от индексации в файле robots.txt.

Как создать и настроить файл robots.txt

Создать файл robots.txt нетрудно, настроить — немного сложнее, однако это тоже можно сделать без специальных знаний.

Создание

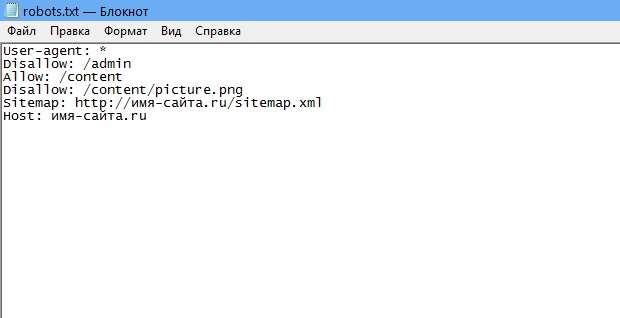

Откройте текстовый редактор — стандартный Блокнот или, например, более продвинутый editor для программистов — Notepad++. Создайте файл в формате .txt, дайте ему имя “robots” и приступайте к заполнению.

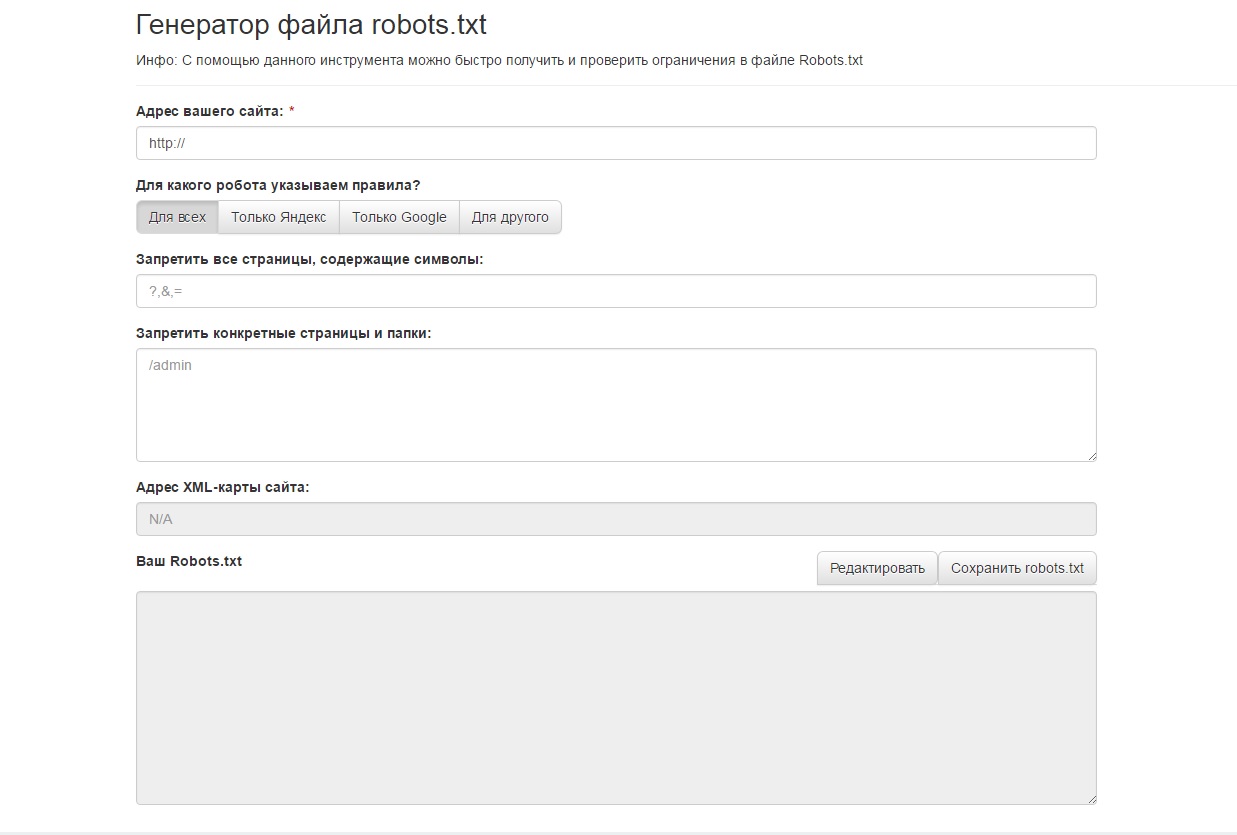

Ещё один способ — создать robots.txt онлайн. Генератор предложит заполнить поля, сам пропишет синтаксис и позволит скачать уже готовый robots.txt. В сети множество инструментов для создания такого типа файлов. К примеру, сервис Seolib.

Интерфейс генератора robots.txt

Редактирование

Если файл создан вручную, текст внутри придётся написать самостоятельно. Если скачан из онлайн-генератора — внимательно проверить и отредактировать содержимое.

Пример блока в файле robots.txt

User-agent — поисковый робот, которому даётся инструкция: например, Googlebot, Yandexbot или * (все роботы).

Allow — разрешающая директива, Disallow — запрещающая.

Host и Sitemap — также обязательные директивы для robots.txt. Первая подсказывает, какое из зеркал сайта следует индексировать, вторая — объясняет, “как пройти” к карте сайта.

В примере мы закрыли роботам доступ к панели администратора, разрешили индексировать содержимое страницы content, правда, исключая файл picture.png. Кроме того, указали основное зеркало сайта и путь к карте сайта.

Заполняя файл robots.txt, стремитесь к краткости — не путайте машину слишком подробными указаниями. Старайтесь сделать инструкцию смысловой и конкретной.

Следите за размером файла robots.txt — у бота Google, к примеру, есть ограничение для него в 500 кб.

Загрузка на сайт

Поместите файл robots.txt в корневую директорию сайта. Он должен отображаться по адресу: имя-сайта.ru/robots.txt. Если файл окажется в другом месте, поисковый робот не станет его искать и просто проигнорирует.

Чтобы загрузить файл robots.txt на сайт, как правило, требуется доступ к протоколу FTP. У популярных CMS также есть функция редактирования файла на панели администратора: по умолчанию или после установки специального модуля.

Проверяем robots.txt

Узнать, на месте ли файл robots.txt, проще простого — перейдите по адресу его расположения: имя-сайта.ru/robots.txt.

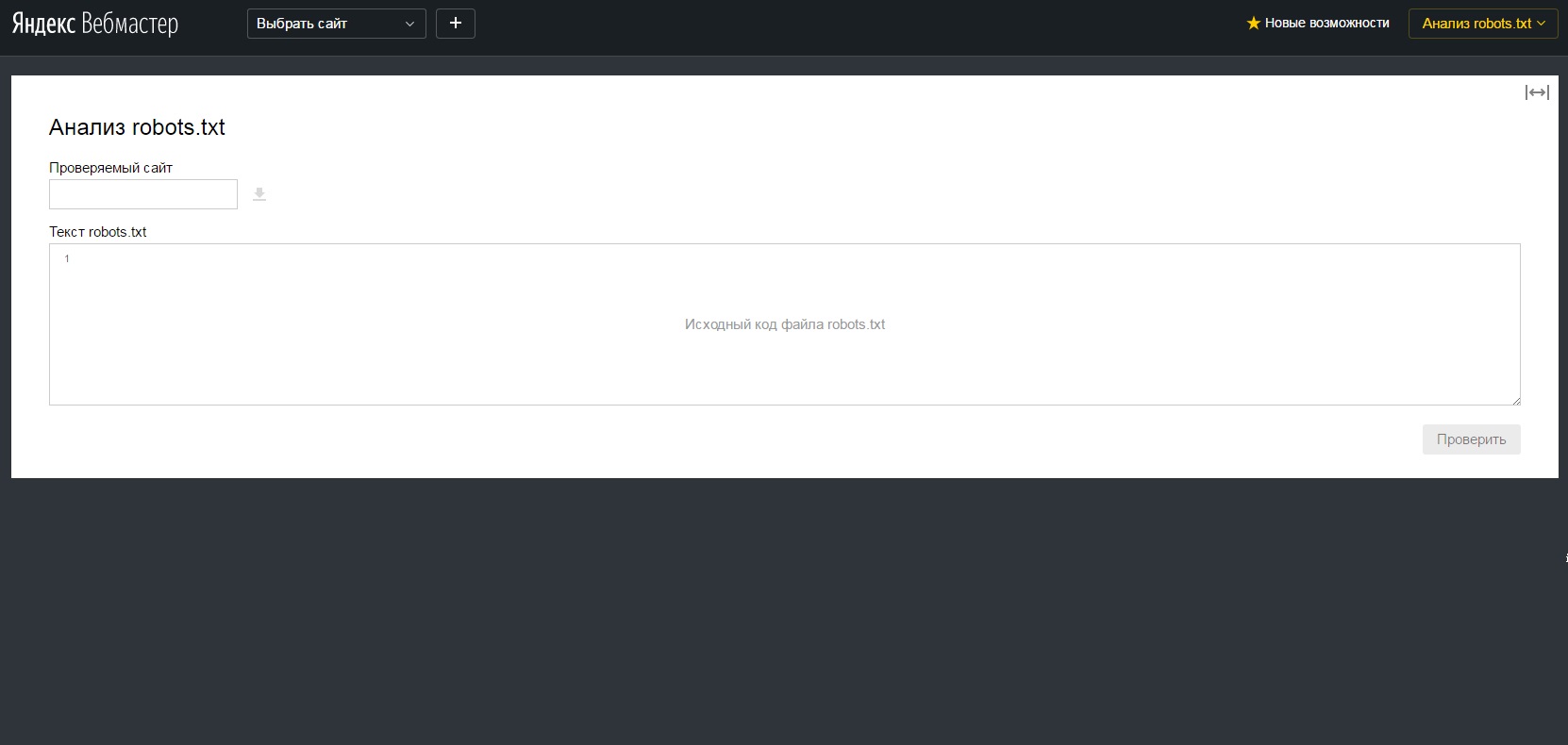

Хотите проверить синтаксис и структуру файла? На помощь придут специальные сервисы поисковых систем для вебмастеров: Яндекс.Вебмастер и Search Console Google.

Анализ robots.txt в Яндекс.Вебмастер

Robots.txt — необходимый “винтик” в механизме веб-ресурса. Возможно, не потребуется он только сайтам-одностраничникам, которые почти не участвуют в seo. Но подстраховаться всё равно можно, тем более что создание файла для сайта с простейшей структурой займёт всего несколько минут.

Подписывайтесь на наш канал в Яндекс.Дзен!

Нажмите "Подписаться на канал", чтобы читать DigitalNews в ленте "Яндекса" .